APLICACIÓN

Soluciones para sistemas de aprendizaje automático

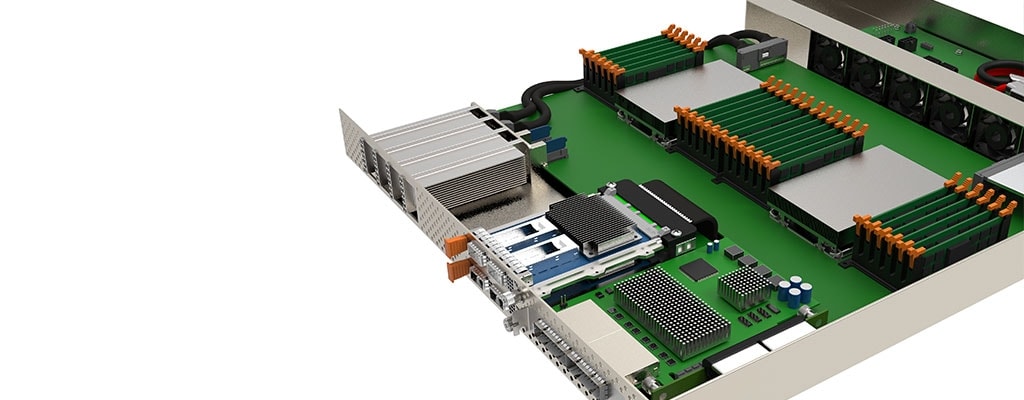

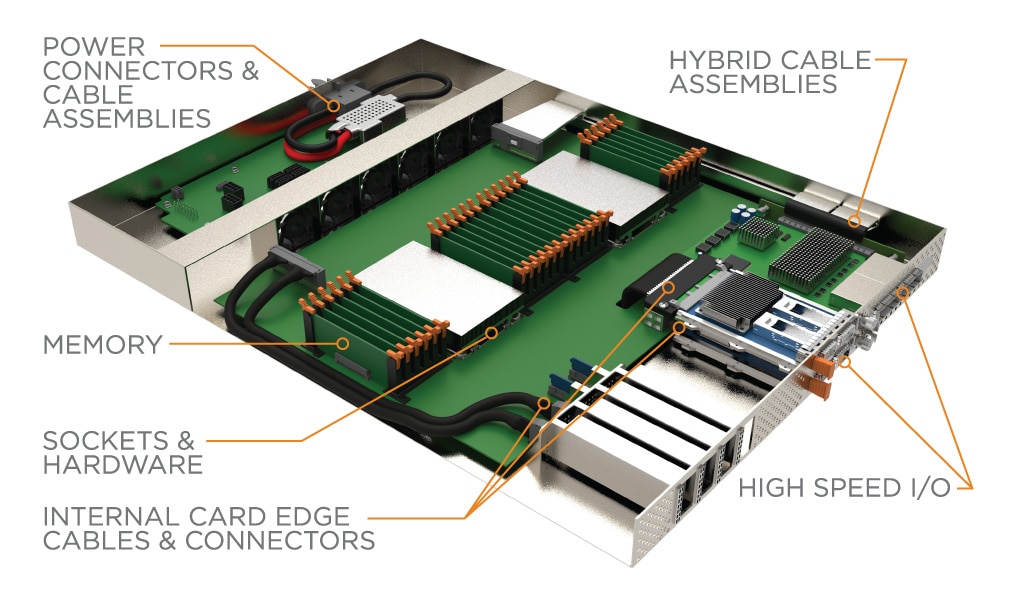

Soluciones de conectividad de alta velocidad y potencia para sistemas de inferencia y aprendizaje automático.

Nuestro mundo está más conectado que nunca con miles de millones de dispositivos de Internet de las cosas en el borde que generan colectivamente una enorme cantidad de datos. Los conocimientos de estos datos cambian la forma en que hacemos negocios, interactuamos con las personas y vivimos nuestra vida cotidiana. La generación de estos conocimientos se produce mediante el procesamiento de los datos a través de redes neuronales para reconocer patrones y categorizar la información. Una vez que se entrena la red neuronal, el modelo se puede implementar para procesar y analizar nuevos datos. Esto se conoce comúnmente como inferencia. El reconocimiento de voz, la detección de objetos, la clasificación de imágenes y la personalización de contenido y los motores de recomendación son aplicaciones cotidianas que pueden aprovechar la inferencia.

Los usuarios finales exigen información en tiempo real en estas aplicaciones, lo que impulsa la inferencia que se produce en dispositivos móviles y en el borde. Los diferentes tipos de aceleradores de hardware, como FPGA, GPU y ASIC, se utilizan para clasificar y caracterizar los datos. Cada uno de estos dispositivos difiere en el procesamiento de caballos de fuerza y consumo de energía y cada uno tiene ventajas dependiendo de la carga de trabajo. Algunos de estos dispositivos se aprovechan tanto para el entrenamiento como para la inferencia, mientras que otros están dedicados a cualquiera de ellos.

- Las matrices de puertas programables en campo (FPGA) se utilizan comúnmente para acelerar los procesos de red y almacenamiento y descargar estas tareas de la CPU.

- Las unidades de procesamiento de gráficos (GPU) están diseñadas para manejar tareas simultáneas y pueden procesar grandes conjuntos de datos de manera más eficiente que las CPU.

- Los circuitos integrados específicos de la aplicación, o ASIC, son procesadores diseñados en torno a cargas de trabajo o tareas específicas para permitir una eficiencia energética óptima.

Los aceleradores de hardware a menudo están conectados a otros dispositivos informáticos y de almacenamiento, agrupados en grandes estructuras y conectados a la red más grande. Las conexiones de red pueden aprovechar protocolos como Ethernet e InfiniBand que normalmente utilizan factores de forma de E/S de alta velocidad como OSFP y QSFP-DD. PCIe se aprovecha para conectar dispositivos de almacenamiento, tarjetas de interfaz de red (NIC) y aceleradores de hardware a la CPU. La familia de conectores y cables Sliver de TE cumple con la especificación SFF-TA-1002 y permite que estos dispositivos se conecten y funcionen a velocidades PCIe Gen 5 y Gen 6.

Compute Express Link (CXL) y Gen-Z son protocolos emergentes y adoptados rápidamente que tienen como objetivo eliminar el cuello de botella de la memoria al permitir la memoria caché coherente. Esto ayuda a impulsar nuevas arquitecturas, creando la necesidad de estructuras PCIe externas que utilizan productos de conectividad como CDFP y Mini-SAS HD.

El conector de placa base de alta velocidad STRADA Whisper de TE y el sistema de cable pueden permitir la modularidad del sistema al ofrecer una conexión de acoplamiento ciego a velocidades de PAM-4 de 112 Gb/s.

e

e

e

e

e

e